Nachdem ich in einem Artikel gezeigt habe, wie man mit Hilfe der robots.txt z. B. die Datenschutzerklärung vor Google verstecken kann, kam es noch zu einem kleinen Konflikt bei einer meiner Seiten mit diesem Vorgehen.

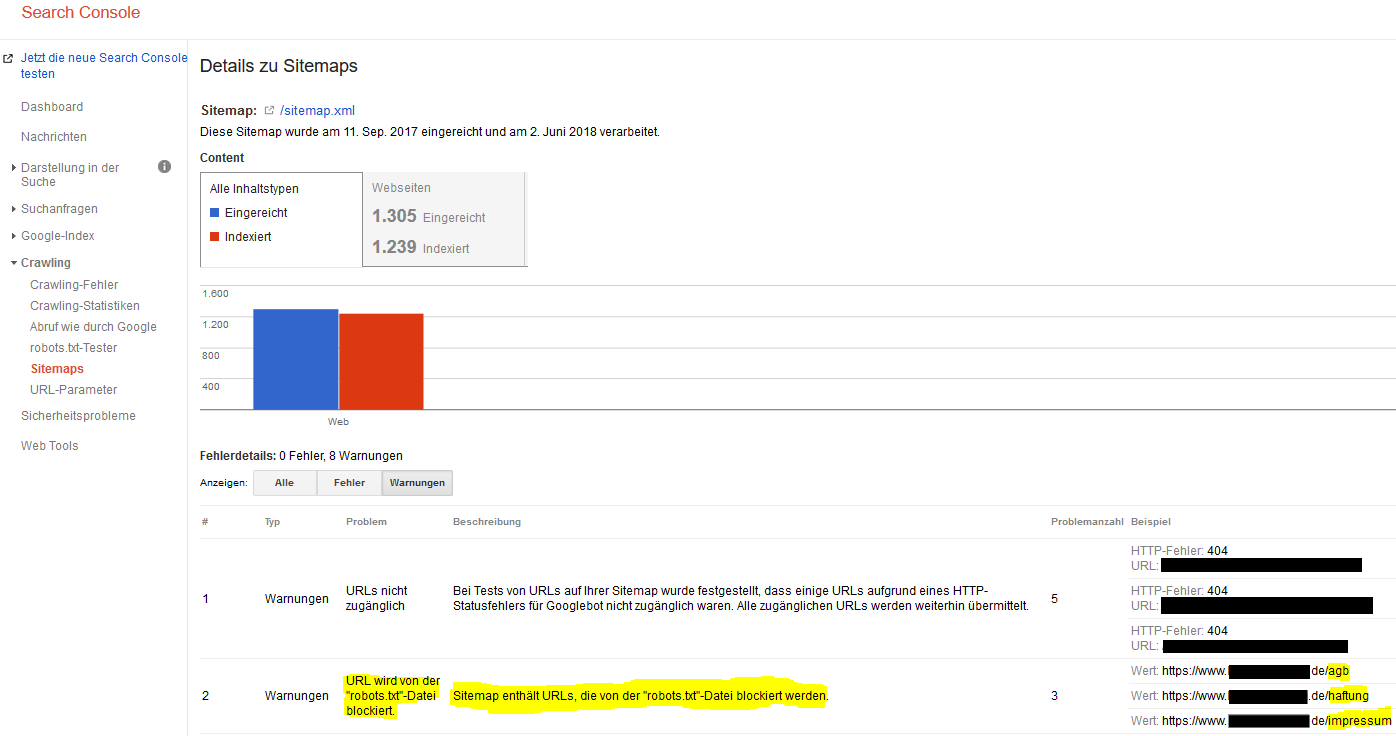

Für eine größere Seite habe ich bei Google in der Search Console eine Warnung bzgl. der betroffenen URLs bekommen, die zwar per robots.txt nicht gecrawlt werden sollen aber in der sitemap.xml blöderweise noch eingetragen waren. Dadurch kann es wohl passieren, dass Google diese trotzdem indexiert.

Die bemängelten versteckten URLs habe ich dann händisch einfach aus der sitemap.xml entfernt und diese neu per FTP hochgeladen und dann in der Google Search Console über „Sitemap hinzufügen/testen“ erneut an Google übermittelt. Einige entfernte Seiten standen dort auch noch drin. Hier kann man also gut mal reinschauen um „aufzuräumen“.

Ebenfalls habe ich dann noch gesehen, dass es einen „Indexabdeckungsfehler“ gegeben hat. Hier war eine Datei indexiert, die mal für alle öffentlich zugänglich gewesen ist, die aber nun in einem per .htaccess geschützten Ordner liegt:

Um dem entgegen zu wirken, habe ich in der Google Search Console unter „Google-Index“ -> „URLs entfernen“ den betroffenen Link einfach angegeben.